О ней постоянно говорят в новостях, а эксперты предупреждают об угрозе, которую они представляют для конфиденциальности, доверия, безопасности и демократии. Но что именно представляет собой технология deepfake? Deepfake – это тип синтетического медиа, в котором искусственный интеллект используется для замены чьего-то изображения или видео на чужое. Эта технология использует сложные алгоритмы ИИ для создания или манипулирования аудио- и видеоконтентом с высокой реалистичностью, который бывает трудно отличить от реальных кадров.

Технология дипфейк представляет собой одно из самых интригующих и противоречивых достижений в области искусственного интеллекта на сегодняшний день. По мере того как технологии, необходимые для создания глубоких подделок, становятся все более доступными, а качество их результатов продолжает улучшаться, они создают все более серьезные проблемы и возможности в различных отраслях, включая СМИ, развлечения, политику и кибербезопасность.

Что такое дипфейк?

Deepfake – это портманто из слов «deep learning» и «fake», используемое для обозначения продвинутой формы искусственного интеллекта и алгоритмов глубокого обучения, применяемых для их создания. В этом методе используются сложные нейронные сети, такие как генеративные состязательные сети (GAN). Для успешного обучения моделей глубокого обучения дипфейкам необходимы высококачественные изображения, аудио- и видеозаписи, чтобы алгоритмы могли уловить такие тонкие особенности, как выражение лица, интонации речи и даже незначительные движения тела. Чем шире и богаче обучающие данные, тем правдоподобнее deepfake.

Эта продвинутая форма ИИ нашла широкое применение в таких отраслях, как развлечения, образование и маркетинг. Однако она также ставит серьезные этические вопросы, связанные с дезинформацией, конфиденциальностью и согласием. Понимание последствий технологии deepfake становится все более важным по мере ее развития и внедрения новых сложностей в цифровой мир.

Читайте также: AI girlfriend: как правильно выбрать себе ИИ-девушку?

Как работают дипфейки?

Создание реалистичных дипфейков и внесение необходимых изменений требует технических знаний, например, использования инструментов для распознавания лица, программ для синтеза голоса и приложений для редактирования видео. Для этого также требуются автокодировщики, которые помогают сжимать и расжимать изображения, чтобы сохранить качество при манипуляциях с ними. Глубокие дипфейки требуют сочетания сложных технологий для создания реалистичных и бесшовных результатов. Продвинутые модели ИИ, такие как GAN и автоэнкодеры, играют важную роль в процессе создания и манипулирования высококачественными изображениями и видео. Методы машинного обучения, распознавание лиц, синтез голоса и инструменты для редактирования видео – все это помогает повысить точность и реалистичность глубоких подделок.

Давайте перечислим некоторые из наиболее распространенных элементов создания deepfake:

- Генеративные адверсарные сети (GAN). Являясь краеугольным камнем технологии deepfake, GAN используют две нейронные сети, которые работают друг против друга, чтобы создавать все более реалистичные изображения или видео.

- Автоэнкодеры. Эти нейронные сети используются для обучения эффективному кодированию данных без контроля. Для глубоких подделок они помогают сжимать и расжимать изображения, чтобы сохранить качество при манипуляциях с ними.

- Алгоритмы машинного обучения. Различные алгоритмы анализируют тысячи изображений или видеокадров, чтобы понять и воспроизвести шаблоны человеческих жестов и мимики.

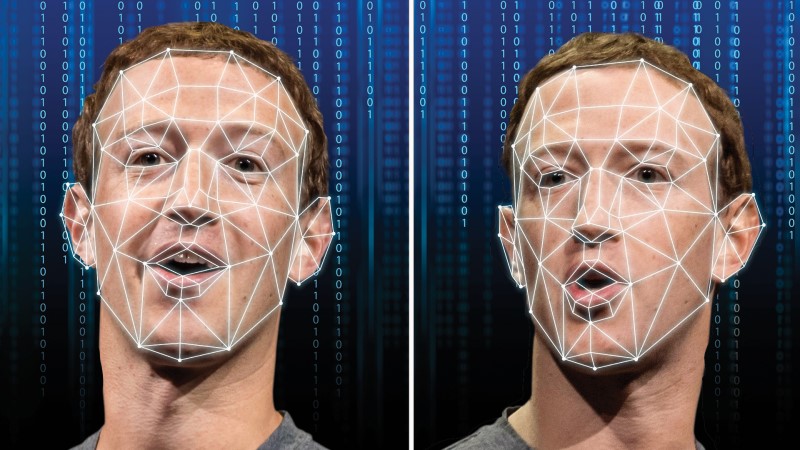

- Распознавание и отслеживание лиц. Эта технология важна для идентификации и отслеживания черт лица, чтобы беспрепятственно менять лица или выражения в видео.

- Синтез голоса и обработка аудио. Передовые инструменты аудио ИИ используются для клонирования голосов и их точной синхронизации с видео, чтобы получить реалистичный звук, соответствующий видеоконтенту.

- Программное обеспечение для редактирования видео. Сложные инструменты для редактирования видео, хотя и не всегда управляемые ИИ, часто используются вместе с технологиями ИИ для доработки результатов и внесения корректировок, повышающих реалистичность.

Процесс создания дипфейков

При создании deepfake используется машинное обучение, которое начинается со сбора высококачественных, согласованных данных и их предварительной обработки для выравнивания и нормализации входных данных. Модель обучается менять местами исходные и целевые объекты + голос. Затем осуществляется постпродакшн и контроль качества, чтобы гарантировать, что конечный продукт выглядит реалистичным и подлинным.

Шаг первый: сбор данных

Чтобы обучающая модель работала лучше, необходимо собрать большую коллекцию изображений и видеороликов с изображением целевого и исходного лица с высоким разрешением для глубокого обучения. Также важно, чтобы эти наборы данных были однородными, чтобы изображения и видео имели схожие характеристики с целевыми. Это поможет снизить уровень шума и артефактов в данных, что повысит производительность модели ИИ.

Шаг второй: предварительная обработка данных

Предварительная обработка включает в себя выравнивание и нормализацию изображений, чтобы гарантировать их согласованность. Это включает в себя распознавание лиц, которое выделяет лицо из остальной части изображения или видео и выравнивает его для последовательного расположения на всех фотографиях или видео. Далее необходимо нормализовать изображение или видео, отрегулировав освещение, цветовой баланс и разрешение изображения, чтобы модель имела согласованные входные данные.

Шаг 3: Обучение модели

Для обучения модели используются автоэнкодеры или GAN. Автоэнкодер учится кодировать исходное лицо и декодировать его в целевое лицо, в то время как GAN используют генератор для создания реалистичных поддельных лиц и дискриминатор для различения настоящих и искусственных лиц. Дискриминатор улучшается со временем.

Шаг 4: Замена предмета

После того как модель обучена, ее можно применить к целевому изображению или видео. Этот этап подразумевает смещение исходного лица на целевое на каждом кадре. Обученная модель автоматически накладывает выражения, углы и особенности исходного лица на структуры лица объекта. Этот метод может потребовать больших вычислительных затрат, особенно для длинных видео, поскольку модель должна обрабатывать тысячи кадров.

Шаг 5: Замена голоса

Для создания глубокого фальшивого голоса используется вокальный синтезатор, синхронизирующий голос, генерируемый ИИ, с целевым звуком. Этот метод имитирует тон, высоту и громкость голоса, что позволяет добиться более реалистичного эффекта. Усовершенствованные алгоритмы следят за тем, чтобы синтезированный голос динамически адаптировался к различным речевым паттернам и настройкам.

Шаг 6: Постобработка отснятого материала

После совмещения генеративного ИИ-контента с целевым изображением или видео проводится постобработка для тонкой настройки конечного результата и повышения его реалистичности. Чтобы получить бесшовные и правдоподобные результаты, в ходе этого процесса часто корректируются освещение, текстуры и переходы.

Шаг 7: Проверка качества

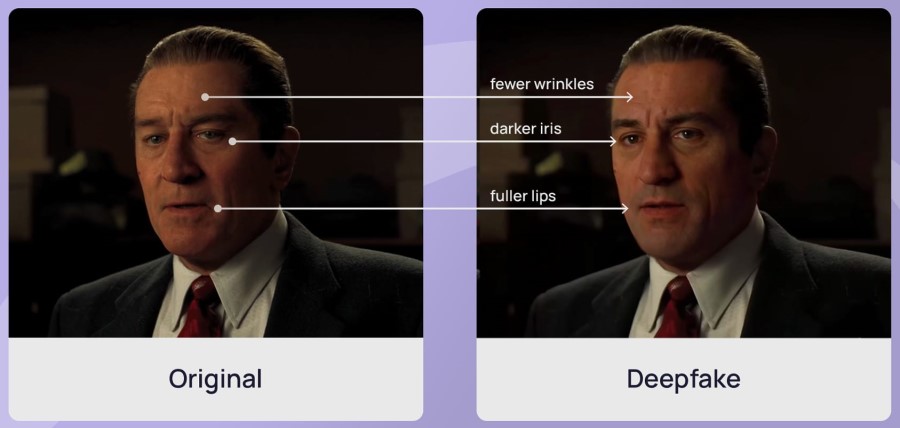

Частью процесса постпроизводства является проверка качества, в ходе которой специалисты по качеству проверяют каждый deepfake на предмет необходимости внесения изменений. Глубокие дипфейки становятся все более реалистичными, и определить, является ли видео или изображение подлинным, становится сложно. Создатели deepfake прогоняют полученный результат через алгоритмы обнаружения, чтобы проверить его подлинность и убедиться, что готовый продукт неотличим от реальных кадров для нетренированного глаза.

Читайте также: Как работает генерация изображений с помощью ИИ?

Положительные примеры применения deepfake

Несмотря на то, что deepfake часто связывают с возможным злоупотреблением, они также стали ценным инструментом в инновационных приложениях. Предлагаем для примера рассмотреть некоторые из наиболее распространенных положительных примеров использования технологии:

- Кинематограф и развлечения. Один из самых интуитивных и разумных примеров применения технологии deepfake – использование ее для усиления визуальных эффектов в кино и на телевидении и замена статистов лицами актеров, которых нет на съемочной площадке.

- Образование и обучение. Дипфейки могут создавать интерактивный образовательный контент, заставляя исторические фигуры или вымышленных персонажей оживать. Это приложение может обеспечить более увлекательный опыт обучения в самых разных условиях – от занятий в классе до сценариев профессиональной подготовки.

- Здравоохранение и терапия. Технология помогает индустрии здравоохранения, улучшая медицинскую визуализацию, разработку лекарств и медицинское обучение с помощью реалистичных симуляций и синтетических данных. Она также помогает врачам и пациентам общаться более эффективно, позволяя переводить язык в режиме реального времени.

- Восстановление изображений и видео. Старые изображения и видео, которые были оцифрованы, выигрывают от использования deepfake. Он улучшает качество и реставрацию этих изображений и видео, предоставляя зрителям более четкие копии.

- Репортаж и подача новостей. Глубоко подделанные репортеры и ведущие теперь используются в некоторых передачах или новостных репортажах — например, чтобы вести репортажи из зон военных действий или погодных явлений, не подвергая риску настоящих журналистов.

Негативные стороны дипфекйов

Несмотря на то, что глубокие подделки имеют ряд положительных применений, они также известны своим вредоносным использованием, которое часто направлено на политиков, знаменитостей и общественных деятелей. Давайте перечислим наиболее распространенные случаи использования технологии deepfake в злонамеренных целях:

- Политическая дезинформация. Дипфейки используются для создания поддельных видеороликов, в которых политики говорят или делают то, чего они никогда не говорили и не делали. Это распространяет дезинформацию и манипулирует общественным мнением.

- Финансовое мошенничество. В финансовом секторе дипфейки могут использоваться и используются для выдачи себя за генеральных директоров и других высокопоставленных руководителей в видеороликах для манипулирования ценами на акции или совершения мошенничества. Эти видео должны быть невероятно убедительными, чтобы привести к значительным финансовым потерям для компаний и инвесторов.

- Злоупотребление изображениями. Знаменитости и общественные деятели часто становятся объектами глубоких подделок: их изображения используются без согласия для создания неуместного или вредного контента. Это вторгается в их частную жизнь и наносит ущерб их публичному имиджу. Несанкционированные deepfake-видеоролики, на которых знаменитости вовлечены в вымышленные или компрометирующие ситуации, распространяются в социальных сетях и на других платформах и являются популярным, но противоречивым применением этой технологии.

К чему это может привести?

Развитие технологии deepfake сопряжено с высокими рисками, которые могут выйти за рамки развлекательных и творческих приложений. К основным рискам, связанным с развитием этой технологии, относится:

- Понижение доверия к СМИ и институтам. Глубокие дипфейки затрудняют различие между реальным и манипулируемым контентом, что приводит к растущему недоверию к СМИ и институтам. Такое разрушение доверия препятствует способности общества принимать обоснованные решения, подрывая демократические процессы и общественные дискуссии.

- Кража личных данных и финансовое мошенничество. Выдача себя за другого, содействие краже личных данных и финансовые преступления – вот лишь некоторые из многочисленных злоупотреблений, связанных с использованием дипфейками. Знаменитости и руководители компаний могут быть эффективно подделаны, чтобы повлиять на цены акций, санкционировать мошеннические операции или обмануть инвесторов, что может привести к большим финансовым потерям.

- Репутационный ущерб и эмоциональное расстройство. Дипфейки могут вызывать эмоциональную реакцию, искажая личные или чувствительные кадры, что часто делается со злым умыслом. Такие кадры способны манипулировать общественными настроениями или стрессами, что имеет серьезные психологические и социальные последствия.

- Угрозы кибербезопасности. Дипфейки представляет собой угрозу кибербезопасности для отдельных лиц и организаций, а также национальной безопасности. Киберпреступники могут использовать deepfake для имитации руководителей или сотрудников, что позволяет проводить сложные фишинговые атаки или мошеннические операции. Дипфейки могут использоваться для распространения дезинформации, подрыва институтов или манипулирования политическими событиями.

- Правда и доверие. Очень реалистичные и убедительные дипфейки подрывают доверие общества к цифровому контенту. С ростом сложности распознать подделку будет еще сложнее, что приведет к всеобщему скептицизму и недоверию ко всем медиа. Это затрудняет способность общества принимать взвешенные решения и подрывает демократические процессы за счет распространения дезинформации.

- Публичный дискурс. Дипфейки могут сфабриковать заявления или действия общественных деятелей, чтобы навязать дезинформацию и запутать общество. Такая манипуляция не только искажает общественное восприятие, но и разжигает пламя поляризации и социальных волнений. Как следствие, развитие технологии представляет собой этическую дилемму, которая требует срочного обсуждения нормативных актов и разработки надежных технологий обнаружения.

Правовые и нормативные перспективы глубоких подделок

По мере развития ИИ, особенно в области deepfake, правительства пытаются решить, как регулировать эти развивающиеся технологии. Страны принимают законы, направленные на борьбу с эксплуатацией ИИ, в частности, в таких областях, как фальсификация выборов, вопросы конфиденциальности и национальной безопасности. Эти ограничения направлены на поиск баланса между инновациями и подотчетностью.

Действующие законы и рамки

Страны решают сложные проблемы, связанные с дипфейками, путем принятия специальных законов, направленных на борьбу с их неправомерным использованием. В Европейском союзе рассматриваются нормативные акты, которые потребуют, чтобы системы искусственного интеллекта, в том числе используемые для создания подделок, были прозрачными и отслеживаемыми, чтобы гарантировать подотчетность.

В Соединенных Штатах, например в Калифорнии, приняты законы, запрещающие распространение порнографии с дипфейками без согласия. Кроме этого, по меньшей мере 14 штатов приняли законы, направленные на борьбу с угрозами, которые несут фейки на выборах, в том числе некоторые из них сделали незаконным использование фейков для вмешательства в выборы.

Глобальные подходы к регулированию

Глобальные меры по регулированию ИИ и фейкового контента различны. В Европе Закон об искусственном интеллекте представляет собой новаторскую нормативную базу, которая не только запрещает применение ИИ с высокой степенью риска, но и обязывает системы ИИ придерживаться основных европейских ценностей. Это законодательство отражает проактивный подход к управлению, в котором приоритет отдается правам человека и прозрачности.

Китайский подход к регулированию ИИ направлен на достижение баланса между контролем и инновациями, а также на решение глобальных проблем ИИ, таких как справедливость, прозрачность, безопасность и подотчетность. Нормативно-правовая база страны призвана управлять стремительным развитием технологий ИИ, чтобы обеспечить их соответствие стандартам национальной безопасности и общественного благосостояния, не сдерживая при этом технологический прогресс.

Эти примеры отражают понимание того, что граждане по всему миру видят растущую потребность в совместных подходах к регулированию для решения сложных, трансграничных проблем, связанных с цифровой информацией и ИИ. Внедрение четкой политики компании в отношении использования ИИ, а также конкретных правил ее реализации способствует большей открытости и ответственности внутри компании.

5 способов обнаружить дипфейк самому

Даже если вы не являетесь графическим дизайнером или видеоредактором, есть способы распознать дипфейки нетренированным глазом. Ниже приведены пять наиболее распространенных признаков, на которые следует обратить внимание:

- Несоответствия в выражениях лица. Дипфейки часто не в состоянии воспроизвести все нюансы человеческой мимики. Например, улыбка может не доходить до глаз, или время выражения эмоции может не совпадать с мимикой. Deepfake-лица также могут выглядеть очень неподвижными и иногда не показывать никаких эмоций. Это те несоответствия, которые делают лица менее реалистичными и более роботизированными, особенно при сложных эмоциональных выражениях.

- Неестественный язык тела. Человеческие движения плавны и скоординированы, но дипфейки иногда могут быть отрывистыми или слишком плавными. Ищите искусственные паузы, неподвижность или движения, которые не соответствуют ситуации, например, слишком плавное вращение головы или нереалистичное движение конечностей.

- Аудио-визуальные несоответствия. Когда человек говорит, движения голоса и рта часто синхронизированы, что свидетельствует о плавном течении коммуникации. Дипфейки отличаются небольшими задержками или преждевременной артикуляцией речи, когда рот не создает правильную форму для определенных слов.

- Плохое освещение и тени. Эффекты света и тени играют важную роль при выявлении подделок. Манипулированные изображения и видео часто демонстрируют несоответствия в освещении и тенях. Освещение и тени в подделках часто не совпадают с фоном или другими частями объекта на исходном изображении или видео.

- Неестественные движения глаз. Движения глаз сложно имитировать фальсификаторами. Чтобы распознать подделку, обратите внимание на глаза, которые не следуют естественным движениям, например, фиксированный взгляд, отсутствие моргания или принудительное моргание, а также глаза, которые двигаются независимо.

3 способа выявления дипфейков с помощью инструментов

Стремительный рост технологий искусственного интеллекта позволил создавать все более изощренные подделки. Однако этот рост привел к появлению новой волны технологий, предназначенных не только для создания, но и для выявления дипфейков. Это позволяет организациям и частным лицам отличать подлинный контент от манипулируемого. Для примера обозначим три наиболее распространенных способа использования инструментов для выявления дипфейков:

- Программное обеспечение. Эти инструменты используют передовые алгоритмы машинного обучения для обнаружения несоответствий, характерных для дипфейков. Программы анализируют видео и изображения на предмет аномалий в выражении лица, движении и текстуре, которые человеческий глаз может пропустить. В качестве примера можно привести Deepware Scanner, Sentinel, FakeCatcher от Intel и Video Authenticator от Microsoft.

- Системы верификации на основе ИИ. Эти системы специально нацелены на выявление реалистичных дипфейков, используемых для манипулирования избирательными процессами или распространения дезинформации. Например, система проверки ИИ компании TrueMedia помогает журналистам и специалистам по проверке фактов, сравнивая подозрительные СМИ с проверенными базами данных для определения подлинности.

- Инструменты для анализа аудио. Для определения достоверности видеоконтента можно анализировать аудиозаписи. Последние инновации McAfee включают в себя технологию обнаружения дипфейк-аудио, которая может точно определить изменения в аудиофайлах. Известный как «Проект Пересмешник», детектор глубоких аудиоподделок McAfee анализирует несоответствия тональности и неестественные речевые паттерны, чтобы выявить поддельный аудиоконтент.

Заключение

Как видите, deepfake уже являются частью нашей реальности, хотим ы этого или нет. Сегодня мы должны научиться отличать подделку от реального контента, для чего нужно понимать не только, как создают дипфейки, но и как их правильно распознавать. По мере развития ИИ-технологий, качество дипфейков будет соответственно расти, поэтому необходимо уже сейчас четко понимать, что любой цифровой контент может быть сфабрикован и ему можно доверять лишь после перепроверки его достоверности.